2. 中国科学院自动化研究所, 北京 100190

2. Institute of Automation of the Chinese Academy of Sciences, Beijing, 100190, China

移动智能体的自主漫游是指智能体在动态场景感知的基础上进行自主建图和定位,从而实现自主导航的功能[1-4]。移动智能体利用该技术,以传感器对周围环境采集的数据作为基础,从中分析和感知环境,进行实时定位的同时创建地图,把自身在地图的位置与环境进行关联。因此,如何使用传感器获取的数据对环境进行感知是移动智能体实现自主漫游的关键。越来越多的研究开始将视觉传感器、激光雷达、惯性传感单元、超宽带基线定位装置等传感器应用于移动智能体的自主漫游中。其中,使用视觉传感器的自主漫游方案最为丰富,该方案在构建可视化地图上具备优势,在室内环境中其有较好的泛用性[5];使用激光雷达的自主漫游方案实用性高,测量精度稳定,使用场景较为广泛[6];惯性传感单元价格经济,是测量移动智能体短时间自身运动状态的良好传感器,但由于其长时间测量误差较大,也无法采集环境信息,因此大多和其他传感器融合使用,作为自主漫游方案的有效补充[7];超宽带基线定位装置虽然定位精度很高,但只适合在室内特定场景使用[8]。

虽然使用多种传感器在机器人导航任务的自主定位[9-11]、自主建图[12, 13]等方面取得了很好的效果,但是考虑到不同传感器的融合特性,激光雷达和RGB-D摄像机因其相对较高的性价比,仍然是机器人在动态场景感知的首要选择。RGB-D摄像机的深度图像和激光雷达提供的信息视图主要有两处不同:①深度信息的视角和范围各不相同。激光雷达提供了水平方向深度信息,而RGB-D摄像机则提供了水平和垂直视角的深度信息[12]。②深度信息中都存在噪声,但产生噪声的原因各不相同。激光雷达深度信息中的噪声通常是由前方可能存在透明玻璃、激光投射的强光吸收和反射等原因造成的;而大部分RGB-D摄像机是通过红外反射来获取深度信息,会因为背光太强、远处或近处的物体超出了反射范围,以及多次红外反射造成测量误差,导致RGB-D图像中存在空洞和斑点毛刺[14]。

目前,研究人员将这两种传感器的深度信息结合,用于机器人的地图绘制[15]和导航定位[16, 17]。然而,由于它们处理信号的原理不同,目前仍缺乏有效的融合方法或深度融合策略。本文提出一种将激光雷达曲线与RGB-D图像的数据融合方法,利用激光雷达曲线和RGB-D图像数据在格式上存在显著差异,但在深度信息上却紧密相对的特点,通过时间配准和相关性分析,发现激光雷达曲线能够在高度上与RGB-D图像配准。同时,本文提出的方法即使不需要校准,RGB-D图像在高度上的相应线条也能自动配准到激光雷达曲线在宽度上的范围。

1 相关工作激光雷达可提供视线前方的水平深度信息,同时得到二维地图中不可获取的导航信息,用于实时闭环[18]、位置识别[19, 20]、障碍物距离估计[21, 22]等任务。RGB-D摄像机获取的深度信息与二维激光雷达不同,它提供了丰富的三维信息,可以实现全视角观测,支持障碍物分割[23]、地图绘制[9, 13]、导航[9, 10]、物体检测[24]等任务。然而,由于三维点云的匹配处理[10, 15, 17]以及RGB-D图像的三维重建[9, 11, 25-28]都非常耗时,因此利用RGB-D图像绘制地图和导航相对复杂。

目前,研究人员将激光雷达曲线和RGB-D图像中的深度信息结合起来用于地图导航。例如,Winterhalter等[16]采用粒子滤波技术估计平面图和真实世界数据之间的6个自由度姿态;Chong等[22]基于合成激光雷达测量和里程计信息,采用蒙特卡罗定位方案进行车辆位置估计;Song等[17]使用基于鲁棒特征的低级视觉-激光雷达融合算法,通过视觉跟踪、结构光传感器的深度信息进行相对定位。这类技术通常被称为地图扫描,主要用于将机器人眼睛看到的范围和位置与完整的激光雷达曲线地图或三维重建环境相匹配。不过,这些方法的目的是通过将激光信息与视觉映射相匹配,减少机器人导航的时间成本并保持定位精度。至于如何融合这两种深度信息,则研究较少。

尽管激光雷达和RGB-D摄像机都能提供深度信息,但它们的成像原理和成像形式却大相径庭。通常,激光雷达的深度信息是由激光投射和反射信号形成的,而RGB-D摄像机的深度信息主要来自环境中的红外反射[14]。在激光雷达和RGB-D摄像机的深度信息中,空洞和毛刺等噪声在位置和范围上是不同的。当激光雷达和RGB-D摄像机放置在相似的高度时[15, 17],有助于将两个传感器的深度信息进行匹配处理。然而,在居家服务机器人、智能送餐机器人、养老陪伴机器人等使用场景上,这两种传感器的放置高度完全不同[12]。在这种情况下,不同高度的深度信息会使它们在视图中的观测差异较大,因此难以对激光雷达和RGB-D摄像机进行校准。因此如何采用一种自动方法来融合激光雷达的二维数据和RGB-D摄像机的深度信息是研究工作中面临的难点问题。

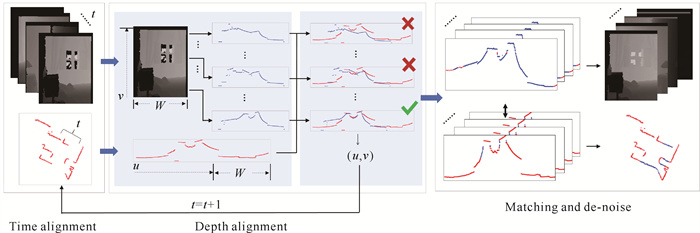

2 基于无需校准激光雷达曲线与RGB-D图像的数据融合方法本文提出的基于无需校准激光雷达曲线与RGB-D图像的数据融合方法主要包括3个步骤:首先,考虑到激光雷达和RGB-D摄像机之间工作频率的差异,采用时间维度来对齐激光雷达的曲线和RGB-D摄像机的深度图像,使得激光雷达曲线采样后频率向RGB-D图像频率对齐。其次,针对激光雷达曲线的宽度范围和RGB-D图像高度范围不统一的问题,采用皮尔逊相关系数、归一化余弦距离和欧拉距离来建立相似度函数,通过沿x轴坐标将RGB-D图像的每一行与激光雷达数据序列对齐; 反之,根据它们的z值沿y轴坐标将激光雷达曲线与RGB-D图像对齐,对于RGB-D图像,x轴是指图像的横坐标,y轴是指图像的纵坐标,z轴表示深度信息度,由此得到激光雷达曲线在某段中和RGB-D图像在某高度处的相似度,并获得它们之间的最佳匹配度。最后,再通过配准和去噪的方法进行水平和垂直初始对齐,消除融合数据的空洞和毛刺。具体流程如图 1所示。

|

| 图 1 本文提出的融合方法的流程 Fig. 1 Workflow of the fusion method proposed in this study |

2.1 时间维度对齐

假设Di(1≤i≤M)和Lj(1≤j≤N)分别为RGB-D摄像机拍摄的第i张深度图像和激光雷达获取的第j张曲线。考虑到两个传感器之间的工作频率差异,采用f(i)/g(j)=t来对齐Di和Lj,其中f(·)和g(·)是RGB-D图像和激光雷达曲线的抽样函数,f(i)和g(j)使得Dt和Lt在时间序列上非常相邻。本文激光雷达曲线的采样频率是1 000 fps,而RGB-D图像的采样频率是24 fps。考虑到激光雷达和RGB-D摄像机之间工作频率的差异,这里取t=1 000/24,使得激光雷达曲线采样后的频率与深度图像的频率对齐。

2.2 激光雷达曲线的宽度范围与RGB-D图像的高度范围对齐假设W和H分别是Di的宽度和高度,Ψ是Lj的宽度,

| $ \begin{array}{l} u, v= \\ \max \left[\arg _{\forall(u, v)} \sum\limits_{v=1}^H \sum\limits_{u=1}^{\Psi-W}\left\|\operatorname{sim}\left(D_{v, w}^t-\hat{L_{u, w}^t}\right)\right\|\right], \end{array} $ | (1) |

其中,1≤u≤Ψ-W,1≤v≤H,0≤sim(·)≤1。

Dv, wt和

| $ \begin{gathered} \operatorname{PCC}\left(D_v, \hat{L_u}\right)= \\ \frac{\operatorname{Cov}\left(D_v, \hat{L_u}\right)}{\sqrt{\operatorname{Var}\left(D_v\right) \operatorname{Var}\left(\hat{L_u}\right)}}= \\ \frac{\mathrm{E}\left(D_v \hat{L_u}\right)-\mathrm{E}\left(D_v\right) \mathrm{E}\left(\hat{L_u}\right)}{\sqrt{\mathrm{E}\left(D_v 2\right)-\mathrm{E}^2\left(\hat{L_u}\right)} \sqrt{\mathrm{E}\left(\hat{L_u} 2\right)-\mathrm{E}^2\left(\hat{L_u}\right)}}, \end{gathered} $ | (2) |

| $ \begin{gathered} \operatorname{Inv}_{\text {Cos }}\left(D_v, \hat{L_u}\right)= \\ 1-{\operatorname{Cos}\left(D_v, \hat{L_u}\right)=} \\ 1-\frac{D_v \cdot \hat{L_u}}{\left\|D_v\right\|\left\|\hat{L_u}\right\|}, \end{gathered} $ | (3) |

| $ \begin{gathered} \operatorname{Inv}_{\text {Euler }}\left(D_v, \hat{L_u}\right)= \\ 1-{\operatorname{Euler}\left(D_v, \hat{L_u}\right)=} \\ 1-\frac{\left\|D_v-\hat{L_u}\right\|}{\max \left(\left\|D_v\right\|, \| \hat{L_u \|}\right)} 。\end{gathered} $ | (4) |

利用公式(1)获得u和v的值后,就能在激光雷达曲线上获得适当的x轴坐标(u)的融合位置,在RGB-D图像上获得适当的y轴坐标(v)的融合位置。尽管激光雷达曲线和RGB-D图像存在空洞和毛刺,但

在平面上相似的两个点集可通过同构法进行变换[33],公式(5)为两个点集使用同构法得到的映射关系,其中激光雷达曲线平面上的m×3点集(L)可通过3×3同构矩阵(A)转换为RGB-D图像垂直面上的m×3点集(D)。

在公式(5)中,(xiL, ziL)和(xiD, ziD)分别是激光雷达曲线和RGB-D图像在(x, z)二维平面上的点值,其中1≤i≤m。

| $ \boldsymbol{L A}=\boldsymbol{D}, $ | (5) |

其中,

假设Dv, wt和

在去噪过程中,β个噪声对中主要包含两种噪声:空洞和毛刺。噪声区域分为3种类型。

① 激光雷达曲线和RGB-D图像的深度数据中的噪声区域都是空洞。

② 激光雷达曲线和RGB-D图像的深度数据中的噪声区域为空洞,其他区域不是空洞。

③ 激光雷达曲线和RGB-D图像的深度数据中的噪声区域为毛刺,其他区域不是毛刺。

类型①中

| $ \exists_{\beta \in W}\left\|\hat L_{u, \beta} \boldsymbol{A}-D_{v, \beta}\right\|>\varepsilon 。$ | (6) |

对于类型②和③,在

| $ \hat{L}_{u, \hat{\alpha}}=D_{v, \alpha} \boldsymbol{A}^{-1}。$ | (7) |

| $ D_{v, \hat \alpha}={\hat L_{u, \alpha}} \boldsymbol{A}。$ | (8) |

值得注意的是,在噪声区域类型①中,

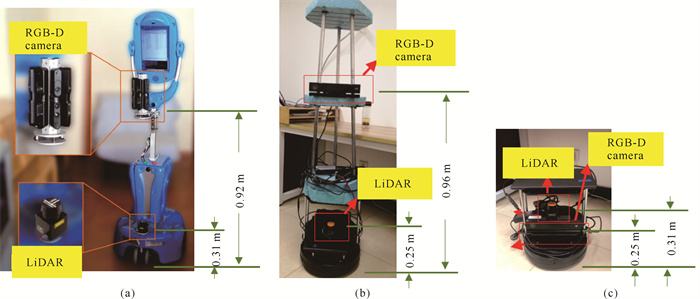

使用室内开放式机器人导航数据集Robot@Home[12](以下简称为“Robot@Home数据集”)对本文提出的融合方法进行评估。Robot@Home数据集收集了来自5个家庭环境的原始数据和经过处理的数据,旨在作为语义映射、机器人定位、二维/三维地图构建和物体分割的基准[34]。该数据集包含1个移动机器人收集的约87 000条有时间标记的观测数据,该移动机器人配备了4个RGB-D摄像机(XTion Pro Live,华硕电脑股份有限公司)和1个激光雷达(URG-04LX-UG01,日本北阳电机株式会社)。在Robot@Home数据集中,激光雷达安装在距离地面约0.31 m的位置,4台RGB-D摄像机安装在距离地面0.92 m的位置。图 2(a)显示了Robot@Home数据集中激光雷达和RGB-D摄像头位置。尽管激光雷达和RGB-D摄像机的视角相似,但Robot@Home数据集中的激光雷达曲线和RGB-D图像并未进行校准。

|

| (a) Height setting position in the Robot@Home dataset; (b)-(c) Two height setting positions in real indoor navigation environment. 图 2 激光雷达和RGB-D摄像机在实验中的高度设置情况 Fig. 2 Height setting positions of LiDAR and RGB-D camera in experiment |

为了进一步验证本文提出的融合方法的有效性,在真实室内导航环境中对本文提出的融合方法进行评估。此实验中,在Turtlebot-2平台上放置1个激光雷达(Hokuyo,日本北阳电机株式会社)和1个RGB-D摄像机[Kinect 2,微软(中国)有限公司],它们分别位于不同高度和相似高度。图 2(b)和(c)展示了这两种情况,图 2(b)中激光雷达和RGB-D摄像机分别放置在距离地面0.25 m和0.96 m的高度(情况1),图 2(c)中分别放置在距离地面0.31 m和0.25 m的高度(情况2)。

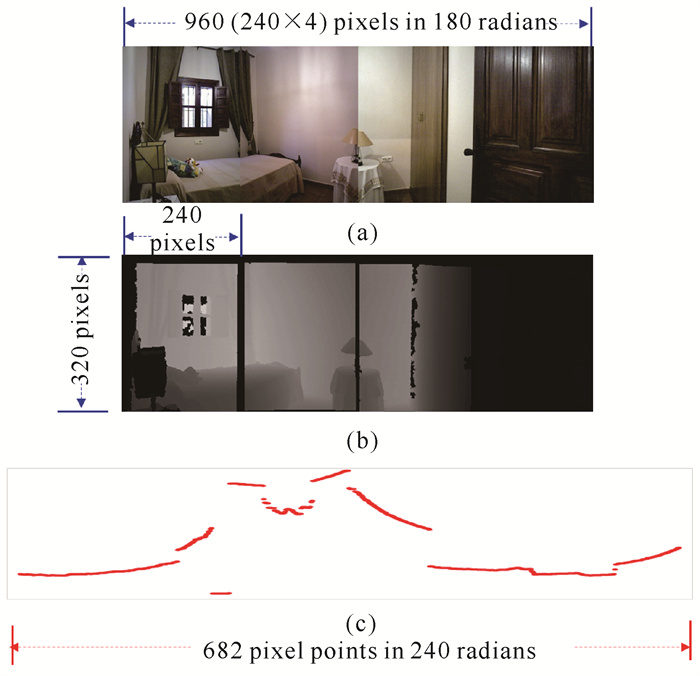

3.2 Robot@Home数据集的实验效果评估在Robot@Home数据集中,4台RGB-D摄像机沿水平方向以180°弧度生成960×320分辨率的图像,1个激光雷达在240°范围内生成每帧682像素的二维曲线。图 3展示了经过处理后时间标记为“130986334520319765”、位置为“alma-s1公寓”的“卧室1”的第4幅RGB图像和RGB-D图像,以及第12幅激光雷达曲线。

|

| 图 3 在Robot@Home数据集中按时间维度对齐的RGB图像(a)、RGB-D图像(b)和激光雷达曲线(c) Fig. 3 RGB image (a), RGB-D image (b) and LiDAR curve (c) aligned by time dimension in the Robot@Home dataset |

3.2.1 Robot@Home数据集上深度对齐的实验评估

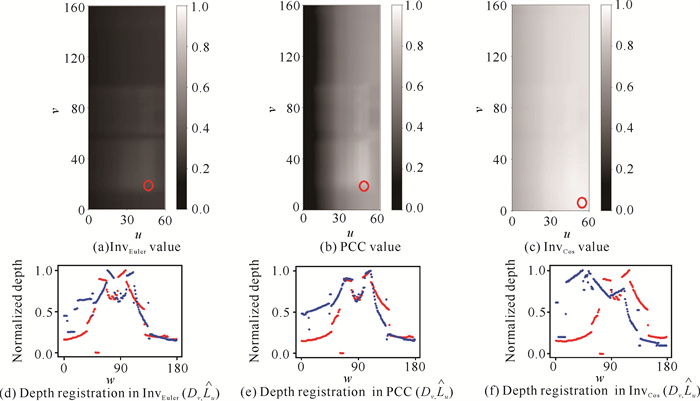

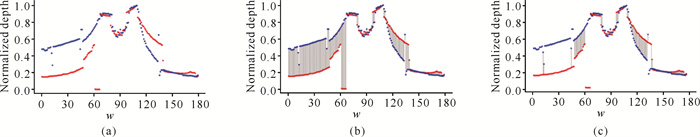

在深度配准步骤中,RGB-D图像水平方向上的960个像素被采样为180个像素,激光雷达曲线沿水平方向的682个像素被采样为240个像素。这样,深度配准的目标就是根据公式(1)同时计算u和v的值。u的取值范围为ω≤u≤ω+W,其中W=240像素,1≤ω≤180,则u的取值范围为0≤u≤420。理论上,v的取值范围为0≤v≤320。但在移动机器人上,激光雷达被安装在较低的位置,因此在实验中v的最大值设定为160像素。通过公式(2)-(4)获得激光雷达曲线在特定区段和RGB-D图像在特定高度的相似度,并确定它们之间的最佳匹配。图 4展示了Dv, wt和

|

| 图 4 激光雷达曲线(红色曲线)和RGB-D图像曲线(蓝色曲线)的InvEuler值、PCC值和InvCos值深度配准的分布情况 Fig. 4 Distribution of InvEuler value, PCC value and InvCos value in depth registration for the LiDAR curve (red curve) and RGB-D image curve (blue curve) |

实验结果表明,PCC值和InvEuler值分布相似,PCC值和InvEuler值最大的位置在(49, 21)附近较为接近,而且图 4(d)和(e)中两条曲线的波动趋势比图 4(f)中的波动趋势更加相关。这表明在深度配准任务中,PCC值和InvEuler值优于InvCos值。此外,从图 4可以看出,PCC值、InvEuler值和InvCos值的范围分别为0.10≤PCC值≤0.80、0.70≤InvEuler值≤0.93和0.10≤InvCos值≤0.35。与InvEuler值和InvCos值相比,PCC值在(0, 1)范围内分布更均匀,这有助于更好地区分u和v。

此外,在0≤v≤160范围内,0≤u≤20范围内的PCC值明显小于40≤u≤60范围内的PCC值。造成这种现象的原因是,在Robot@Home数据集中,激光雷达位于离地面0.31 m的高度,而RGB-D摄像机位于离地面0.92 m的高度。有些物体放置在地面上,离机器人非常近。图 3(a)左侧床边放置了一个矮柜,大部分矮柜没有出现在RGB-D图像中,而是由激光雷达扫描到的。因此,激光雷达的像素无法与RGB-D曲线同一高度的像素匹配。在图 4(d)和(e)中,10≤u≤20范围内的红色点为橱柜,而同一范围内的蓝色点为床的前部。激光雷达和RGB-D图像在此范围内的点的PCC值较低。而对于图 4(d)和(e)中位于60≤w≤180右侧范围内的点,红色的点比左侧部分的点更接近蓝色的点。这是因为图 3(a)和(b)右侧部分的场景非常开阔,在激光雷达之前没有矮小物体。

表 1表示Robot@Home数据集中最大公寓“sarmis-s1”中7个房间的最大PCC值,它们分别位于低(0.0<PCC值<0.3)、中(0.3<PCC值<0.6)和高(0.6<PCC值<1.0)范围内。从表 1可以看出,“corridor1”房间的高得分率为66.67%,明显高于“bedroom3”房间(18.48%)和“bedroom1”房间(20.10%)。造成这一现象的原因是在Robot@Home数据集中,“corridor1”房间的场景明显比其他房间更加开放。

| 房间 Room |

范围 Range |

高得分率/% High scoring rate/% |

||

| 低 Low |

中 Middle |

高 High |

||

| bedroom1 | 28 | 316 | 92 | 21.10 |

| bedroom2 | 20 | 212 | 56 | 19.44 |

| bathroom2 | 16 | 84 | 24 | 19.35 |

| bedroom3 | 44 | 256 | 68 | 18.48 |

| corridor1 | 0 | 72 | 144 | 66.67 |

| kitchroom1 | 4 | 120 | 20 | 13.89 |

| livingroom1 | 28 | 196 | 76 | 25.33 |

| Note: the bold data are the best data in the table. | ||||

3.2.2 Robot@Home数据集上配准的实验评估

使用

|

| (a) LiDAR curve (red curve) points and RGB-D image (blue curve) depth points; (b) Matching line between LiDAR curve (red curve) points and RGB-D image (blue curve) depth points; (c) Matching line between LiDAR curve (red curve) points and RGB-D image (blue curve) depth points after removal of outliers. 图 5 激光雷达曲线点和RGB-D图像曲线对齐后的配准过程 Fig. 5 Registration process of LiDAR curve points and RGB-D image depth points after aligning |

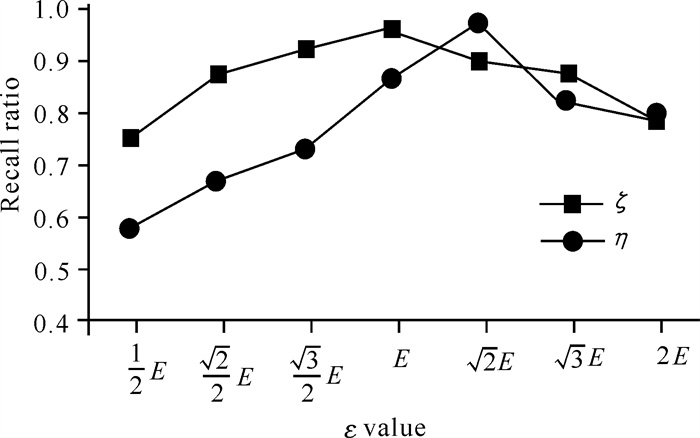

不同ε值的良好匹配对和噪声对的召回率实验结果如图 6所示。

|

| 图 6 不同ε值的良好匹配对和噪声对的召回率 Fig. 6 Recall ratio of good matching and noise matching under different ε values |

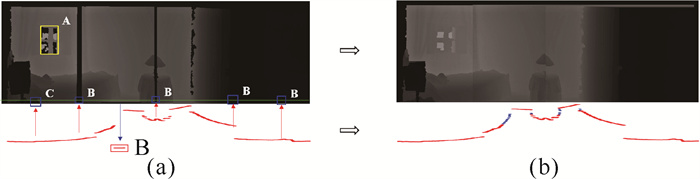

3.2.3 Robot@Home数据集上去噪的实验评估

图 7展示了时间标记为“130986334520319765”、位置为“alma-s1公寓”的“卧室1”的第4幅RGB-D图像和第12幅激光雷达曲线的去噪结果,图 7(a)为原始的RGB-D图像和激光雷达曲线,图 7(b)为去噪后的RGB-D图像和激光雷达曲线。原始RGB-D图像底部的浅绿色线条表示激光雷达与RGB-D图像深度对齐的位置。标有“A”“B”和“C”的图块表示了2.3.2节中提到的3种噪声区域类型,即激光雷达曲线中红色图块中的点是空心的,其深度值由从RGB-D图像中提取的相应深度信息修复,这些信息用蓝色箭头标示。同样,RGB-D图像中位于绿线上的蓝色块中的点是空心的,它们的深度值由从激光雷达曲线中提取的相应深度信息修复,该信息由红色箭头标注。这样,原始的激光雷达曲线和RGB-D图像就可以相互去噪。去噪后,激光雷达曲线中的蓝色像素点为本文提出的融合方法给出的建议修复点[图 7(b)]。

|

| 图 7 Robot@Home数据集场景的去噪结果 Fig. 7 Denoising results of the Robot@Home dataset scene |

本文提出的融合方法在Robot@Home数据集中的评估结果表明,皮尔逊相关系数在深度配准方面的效果相对优于归一化余弦距离和欧拉距离(图 5和表 1)。此外,对于PCC值较高的开阔场景,激光雷达曲线能够在RGB-D图像的高度上进行配准,同时RGB-D图像也能在水平方向上与激光雷达曲线自动配准。此外,图 6和图 7表明,RANSAC算法结合同构法能够区分激光雷达曲线和RGB-D图像配准后的噪声。

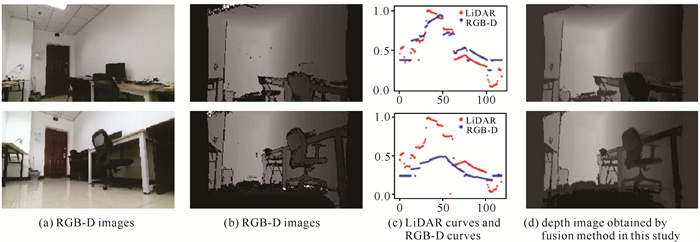

3.3 真实室内导航环境中的实验分析移动机器人在真实室内导航环境获取的数据如图 8所示,其中上图和下图分别对应激光雷达和RGB-D摄像机高度设置情况1和情况2得到的图片,[图 8: (a)-(d)]分别为RGB图像、RGB-D图像、激光雷达曲线(红色曲线)和RGB-D曲线(蓝色曲线)、经本文提出的融合方法融合后的深度图像。根据图 8(b)和(d)的对比可以看到本文提出的融合方法能够获得较好的配准融合结果。

|

| 图 8 移动机器人在真实室内导航环境中获得的图像 Fig. 8 Images obtained by moving robot in real indoor nevigation environment |

3.4 在Robot@Home数据集和真实室内导航环境数据中的融合效果对比

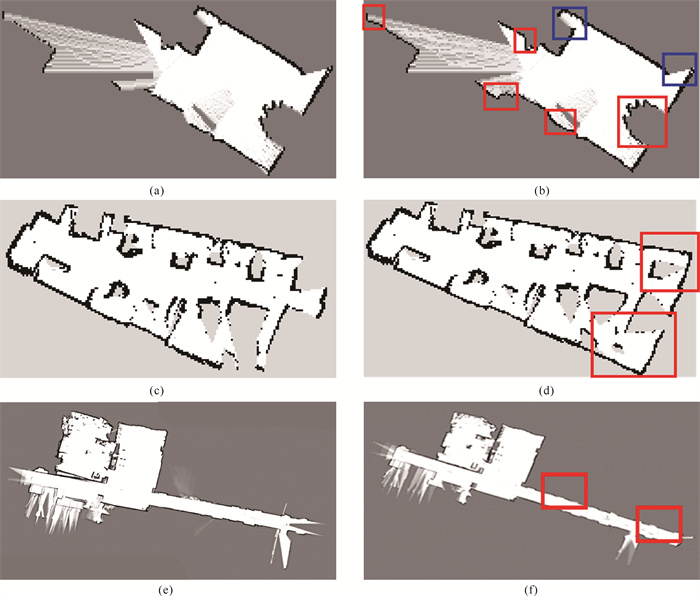

为了更进一步验证本文提出的融合方法,将该方法在Robot@Home数据集和真实导航环境数据中的融合效果进行对比。图 9(a)和(b)分别为通过Robot@Home数据集中“alma-s1”样本“bedroom1”房间的激光雷达数据生成的原始二维地图和经本文提出的融合方法得到的二维地图,图 9(c)和(d)分别为由真实室内导航环境数据实验房间的激光雷达数据生成的原始二维地图和经本文提出的融合方法得到的二维地图,图 9(e)和(f)分别为由真实室内导航环境数据实验房间所在楼层的激光雷达数据生成的原始二维地图和经本文提出的融合方法得到的二维地图。从图 9(b)可以看出,红色区块中遗漏的边界在融合方法中得到了明显的改善和修复。此外,在蓝色图块的一些区域中,Robot@Home数据集没有显示其正视图,因此这些区域的激光雷达曲线和RGB-D图像都没有深度信息。图 9(d)中二维地图的右下角和右上角红色区域比图 9(c)显示了更完整的信息,同时图 9(f)中二维地图的中心和右下角区域比图 9(e)显示了更为平滑的效果,并且消除了毛刺的影响。这是因为在这两个角落,激光雷达的深度信息由于桌子两侧的遮挡而部分为0。而RGB-D摄像机提供的深度信息则包含了桌子和墙壁的全部深度信息,RGB-D图像可补充激光雷达曲线的深度信息,从而得到融合结果更好的二维地图。

|

| (a)-(b): 'bedroom1' in the 'alma s1' sample in the Robot@Home dataset; (c)-(d): the room of real indoor navigation environment experiment; (e)-(f): the floor of real indoor navigation environment data experimental room. 图 9 激光雷达数据生成的原始二维地图和经本文提出的融合方法得到的二维地图 Fig. 9 Original 2D map generated by LiDAR data and 2D map generated by fusion method in this study |

4 结论

本文提出了一种基于无需校准的激光雷达和RGB-D图像的数据融合方法,并通过在Robot@Home数据集和真实的机器人室内环境中对本文方法进行了评估,实验结果表明,本文方法有助于去除原始数据的噪声,并在无需校准的情况下同时为激光雷达曲线和RGB-D图像提供更准确的细节信息。本文方法可以扩展到更精确的二维地图构建和三维场景重构中,用于机器人导航等应用领域。

| [1] |

ZOU Q, SUN Q, CHEN L, et al. A comparative analysis of LiDAR SLAM-based indoor navigation for autonomous vehicles[J]. IEEE Transactions on Intelligent Transportation Systems, 2022, 23(7): 6907-6921. DOI:10.1109/TITS.2021.3063477 |

| [2] |

ZHOU Z, FENG X, DI S, et al. A LiDAR mapping system for robot navigation in dynamic environments[J]. IEEE Transactions on Intelligent Vehicles, 2023, 8(7): 1-20. DOI:10.1109/TIV.2023.3296969 |

| [3] |

SONG Y, XU F, YAO Q, et al. Navigation algorithm based on semantic segmentation in wheat fields using an RGB-D camera[J]. Information Processing in Agriculture, 2023, 10(4): 475-490. DOI:10.1016/j.inpa.2022.05.002 |

| [4] |

KOLHATKAR C, WAGLE K. Review of SLAM algorithms for indoor mobile robot with LiDAR and RGB-D camera technology [C]//Innovations in Electrical and Electronic Engineering. Singapore: Springer Singapore, 2021: 397-409.

|

| [5] |

VULPI F, MARANI R, PETITTI A, et al. An RGB-D multi-view perspective for autonomous agricultural robots[J]. Computers and Electronics in Agriculture, 2022, 202: 107419. DOI:10.1016/j.compag.2022.107419 |

| [6] |

MUÑOZ-BAÑÓN M Á, VELASCO-SÁNCHEZ E, CANDELAS F A, et al. OpenStreetMap-based autonomous navigation with LiDAR naive-valley-path obstacle avoidance[J]. IEEE Transactions on Intelligent Transportation Systems, 2022, 23(12): 24428-24438. DOI:10.1109/TITS.2022.3208829 |

| [7] |

PATOLIYA J, MEWADA H, HASSABALLAH M, et al. A robust autonomous navigation and mapping system based on GPS and LiDAR data for unconstraint environment[J]. Earth Science Informatics, 2022, 15(4): 2703-2715. DOI:10.1007/s12145-022-00791-x |

| [8] |

HAO X, REN W, CHOO K R, et al. A self-trading and authenticated roaming scheme based on blockchain for smart grids[J]. IEEE Transactions on Industrial Informatics, 2022, 18(6): 4097-4106. DOI:10.1109/TII.2021.3119963 |

| [9] |

TIAN B, SHIM V A, YUAN M, et al. RGB-D based cognitive map building and navigation [C]//2013 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, NJ: IEEE, 2013: 1562-1567.

|

| [10] |

WELLHAUSEN L, RANFTL R, HUTTER M. Safe robot navigation via multi-modal anomaly detection[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 1326-1333. DOI:10.1109/LRA.2020.2967706 |

| [11] |

FU Y, YAN Q, YANG L, et al. Texture mapping for 3D reconstruction with RGB-D sensor [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2018: 4645-4653.

|

| [12] |

RUIZ-SARMIENTO J R, GALINDO C, GONZALEZ-JIMENEZ J. Robot@Home, a robotic dataset for semantic mapping of home environments[J]. The International Journal of Robotics Research, 2017, 36(2): 131-141. DOI:10.1177/0278364917695640 |

| [13] |

KAZEROUNI I A, FITZGERALD L, DOOLY G, et al. A survey of state-of-the-art on visual SLAM[J]. Expert Systems with Applications, 2022, 205: 117734. DOI:10.1016/j.eswa.2022.117734 |

| [14] |

KUAN Y W, EE N O, WEI L S. Comparative study of intel R200, Kinect v2, and primesense RGB-D sensors performance outdoors[J]. IEEE Sensors Journal, 2019, 19(19): 8741-8750. DOI:10.1109/JSEN.2019.2920976 |

| [15] |

SHIN Y S, PARK Y S, KIM A. Direct visual SLAM using sparse depth for camera-LiDAR system [C]//2018 IEEE International Conference on Robotics and Automation (ICRA). Piscataway, NJ: IEEE, 2018: 5144-5151.

|

| [16] |

WINTERHALTER W, FLECKENSTEIN F, STEDER B, et al. Accurate indoor localization for RGB-D smartphones and tablets given 2D floor plans [C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Piscataway, NJ: IEEE, 2015: 3138-3143.

|

| [17] |

SONG H, CHOI W, KIM H. Robust vision-based relative-localization approach using an RGB-depth camera and LiDAR sensor fusion[J]. IEEE Transactions on Industrial Electronics, 2016, 63(6): 3725-3736. DOI:10.1109/TIE.2016.2521346 |

| [18] |

HESS W, KOHLER D, RAPP H, et al. Real-time loop closure in 2D LIDAR SLAM [C]//2016 IEEE International Conference on Robotics and Automation (ICRA). Piscataway, NJ: IEEE, 2016: 1271-1278.

|

| [19] |

HIMSTEDT M, FROST J, HELLBACH S, et al. Large scale place recognition in 2D LiDAR scans using geometrical landmark relations [C]//2014 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, NJ: IEEE, 2014: 5030-5035.

|

| [20] |

ARRAS K O, MOZOS O M, BURGARD W. Using boosted features for the detection of people in 2D range data [C]//Proceedings 2007 IEEE International Conference on Robotics and Automation. Piscataway, NJ: IEEE, 2007: 3402-3407.

|

| [21] |

BRACHMANN E, ROTHER C. Learning less is more-6D camera localization via 3D surface regression [C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2018: 4654-4662.

|

| [22] |

CHONG Z J, QIN B, BANDYOPADHYAY T, et al. Synthetic 2D LIDAR for precise vehicle localization in 3D urban environment [C]//2013 IEEE International Conference on Robotics and Automation. Piscataway, NJ: IEEE, 2013: 1554-1559.

|

| [23] |

DAI J, LI X, WANG K, et al. A novel STSOSLAM algorithm based on strong tracking second order central difference Kalman filter[J]. Robotics and Autonomous Systems, 2019, 116: 114-125. DOI:10.1016/j.robot.2019.03.006 |

| [24] |

HOLZ D, HOLZER S, RUSU R B, et al. Real-time plane segmentation using RGB-D cameras [M]//RoboCup 2011: Robot Soccer World Cup XV. Berlin, Heidelberg: Springer Berlin Heidelberg, 2012: 306-317.

|

| [25] |

HOLZ D, ICHIM A E, TOMBARI F, et al. Registration with the point cloud library: a modular framework for aligning in 3-D[J]. IEEE Robotics & Automation Magazine, 2015, 22(4): 110-124. |

| [26] |

HOU X, SHI H, QU Y, et al. A fusion method for 2D LiDAR and RGB-D camera depth image without calibration[M]. Singapore: Springer Nature Singapore, 2023: 89-101.

|

| [27] |

HUANG Y, ZHU M, ZHENG Z, et al. Homography-based visual servoing for underactuated VTOL UAVs tracking a 6-DOF moving ship[J]. IEEE Transactions on Vehicular Technology, 2022, 71(3): 2385-2398. DOI:10.1109/TVT.2021.3138912 |

| [28] |

LIAN W, ZHANG L, ZHANG D. Rotation-invariant nonrigid point set matching in cluttered scenes[J]. IEEE Transactions on Image Processing, 2012, 21(5): 2786-2797. DOI:10.1109/TIP.2012.2186309 |

| [29] |

POMERLEAU F, COLAS F, SIEGWART R, et al. Comparing ICP variants on real-world data sets[J]. Autonomous Robots, 2013, 34(3): 133-148. DOI:10.1007/s10514-013-9327-2 |

| [30] |

WANG D Z, POSNER I, NEWMAN P. Model-free detection and tracking of dynamic objects with 2D lidar[J]. International Journal of Robotics Research, 2015, 34(7): 1039-1063. DOI:10.1177/0278364914562237 |

| [31] |

WANG Y, WEI X, SHEN H, et al. Robust fusion for RGB-D tracking using CNN features[J]. Applied Soft Computing, 2020, 92: 106302. DOI:10.1016/j.asoc.2020.106302 |

| [32] |

YLIMÄKI M, HEIKKILÄ J, KANNALA J. Accurate 3-D reconstruction with RGB-D cameras using depth map fusion and pose refinement [C]//201824th International Conference on Pattern Recognition (ICPR). Piscataway, NJ: IEEE, 2018: 1977-1982.

|

| [33] |

ZHONG J, LI M, LIAO X, et al. A real-time infrared stereo matching algorithm for RGB-D cameras'indoor 3D perception[J]. ISPRS International Journal of Geo-Information, 2020, 9(8): 472. DOI:10.3390/ijgi9080472 |

| [34] |

ZHOU S K, LE H N, LUU K, et al. Deep reinforce-ment learning in medical imaging: a literature review[J]. Medical Image Analysis, 2021, 73: 102193. DOI:10.1016/j.media.2021.102193 |

| [35] |

ZLOT R, BOSSE M. Place recognition using keypoint similarities in 2D lidar maps [M]//Experimental Robotics. Berlin, Heidelberg: Springer Berlin Heidelberg, 2009: 363-372.

|