2. 南京邮电大学,江苏省大数据安全与智能处理重点实验室,江苏南京 210023;

3. 东南大学计算机科学与工程学院,江苏南京 210023

2. Jiangsu Key Laboratory of Big Data Security & Intelligent Processing, Nanjing University of Posts and Telecommunications, Nanjing, Jiangsu, 210023, China;

3. School of Computer Science and Engineering, Southeast University, Nanjing, Jiangsu, 210023, China

深度神经网络基于大规模标注训练数据,在众多机器感知任务上取得了优秀的性能,然而大规模人工标注意味着高昂的数据标注代价,限制了深度神经网络在数据标注不足任务上的应用。近年来,备受关注的域适应(Domain Adaptation, DA)学习尝试采用标签丰富的源域来帮助标签稀缺的目标域学习[1],在许多任务上性能得到了显著的提升。

近年来,域适应学习方法相继涌现,可大致分为3类,分别为基于差异的方法、基于对抗的方法以及基于重构的方法。基于差异的域适应方法旨在缩小域间的分布差异,常用的差异性度量包括最大均值差异(Maximum Mean Discrepancy,MMD)[2]、KL散度[3]和Wasserstein距离[4]等。基于对抗的方法通过对抗学习方式生成域不变特征。例如,DANN[5]和DA2NN[6]等采用特征提取器和域鉴别器间的博弈和对抗,而MCD[7]则利用两个分类器间的对抗学习产生域不变特征。基于重构的方法通过对抗生成跨域样本实现域迁移,如cycle-GAN[8]、CyCADA[9]等方法。尽管这些方法可有效提升目标域的学习性能,但都假设存在大量正确标记的源域数据,在许多真实学习任务中很难满足。在含噪声的DA学习中,噪声源实例可能会导致负迁移现象[1],限制了DA方法的实际应用。有文献研究从理论上证明了源域中的标签噪声会给DA学习带来严重的负迁移问题[10]。也有学者研究了更通用的噪声DA场景,包括标签噪声、特征噪声以及混合噪声[11]。

DA方法通常假设存在一个已正确标记的源域,然而在现实任务中,精确的人工标注耗时耗力,通常很难收集大量带有干净标签的源实例。虽然很容易从网络和社交媒体中采集数据,但是此类数据集可能存在标签噪声。带有噪声源标签的噪声DA学习可能会损害目标域的学习性能,但针对此问题的研究仍然有限。

带噪声标签的鲁棒学习目前已获得广泛研究。噪声标签学习方法可大致分为3类:基于无偏损失或风险最小化[12-15]、基于自助(Bootstrapping)损失[16]以及噪声样本重采样方法[17-20]。基于无偏损失或风险最小化方法旨在定义可有效抑制噪声数据的损失函数。基于自助损失方法通过在训练过程中不断修正数据标签来减轻噪声标签实例对模型学习的影响。噪声样本重采样方法则通过设计从训练损失到样本权重的映射函数,根据损失计算样本权重,最小化分类器更新的加权实例损失。此外,根据是否使用转移矩阵对标签噪声进行显式建模,将带标签噪声的鲁棒学习方法分为基于转移矩阵法和无转移矩阵法,本研究属于第二类,不同的是本研究场景更具挑战性,旨在将含有噪声标签的源域知识迁移至目标域,以提升目标域的学习性能。

针对源域存在噪声标签的学习场景,本文提出基于自适应噪声校正的鲁棒域适应学习方法(Robust DA Method through Adaptive Noise Correction,RoDAC)。首先,通过自适应噪声检测(Adaptive Noisy Label Detection, ANLD)识别噪声源实例、加权实例损失以及减少噪声实例对分类学习的贡献,同时划分数据集以进一步减少其对域适应学习的影响;接着,通过自适应噪声标签校正(Adaptive Noisy Label Correction, ANLC)修正噪声实例,使噪声实例获得更为准确的标签,并重新投入学习。

1 自适应噪声校正的鲁棒域适应学习方法在源域标签存在噪声的域适应学习场景中,主要挑战在于:①如何减少噪声标签对分类学习的影响;②如何减少噪声标签对域间分布对齐的影响。因此,本文提出了一个系统的解决方案,主要包括两个学习阶段:自适应噪声标签检测(ANLD)和自适应噪声标签校正(ANLC)。

1.1 符号定义和网络结构为方便描述,首先给出符号定义,噪声标签源域数据和无标签目标域数据分别表示为(Xs, Ys)={(xis, yis)}i=1ns和Xt={(xit)}i=1nt,其中,ns和nt分别表示源域和目标域样本数;s和t分别代表源域和目标域。

进一步地,采用数学符号来表述本文的研究目标。将成对标签上的损失函数定义为L:Y×Y→

|

| 图 1 标签噪声DA学习过程 Fig. 1 Label noise DA learning process |

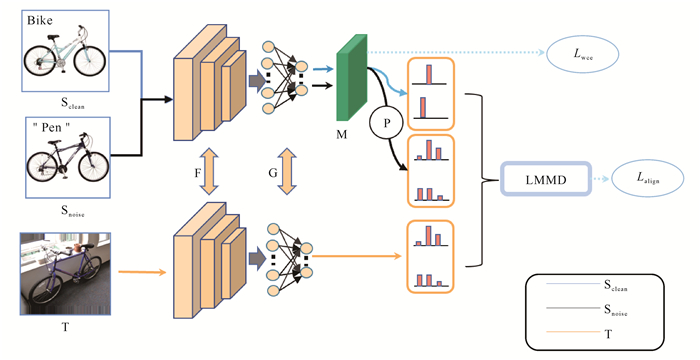

RoDAC利用干净实例的small-loss[21]基于元网络自适应地区分干净和噪声实例,同时,基于数据的聚簇特性,利用原型分类器对检测出的噪声实例进行自适应校正,并重新投入域适应学习中。RoDAC的网络结构如图 2所示。其中,F为特征提取器,G为多层感知分类器,源域和目标域共享F和G。M为基于元网络的自适应噪声检测器,用于自适应地检测噪声实例。P为原型分类器,用于自适应地校正噪声实例。通过局部最大均值差异(Local Maximum Mean Discrepancy, LMMD)[22]计算源域与目标域间的条件分布差异,并缩小域间的分布距离,实现源域知识迁移。

|

| 图 2 RoDAC网络结构图 Fig. 2 Network structure diagram of RoDAC |

1.2 自适应噪声标签检测

由于源域存在噪声标签,源域学习可能会错误地拟合噪声实例,并将错误知识迁移至目标域。鉴于此,RoDAC通过基于元网络的自适应噪声标签检测器来识别噪声实例。首先,利用元网络自适应地对源域实例进行加权,权值大小用来描述其属于干净样本的可能性,从而降低噪声标签对分类学习的影响。接着,基于阈值法将源域数据集划分为干净实例集Xcleans和噪声实例集Xnoises,并在ANLC中校正噪声标签,用于提升域间对齐和源域迁移知识。

1.2.1 实例损失加权若仅考虑源域上的监督分类任务,分类学习损失可表示为

| $ \min\limits _f \frac{1}{n_{\mathrm{s}}} \sum_{i=1}^{n_{\mathrm{s}}} J\left(f\left(x_i^{\mathrm{s}} ; \theta\right), y_i^{\mathrm{s}}\right), $ | (1) |

式中,J是交叉熵损失函数,f是由θ参数化的假设函数。为减少噪声标签对分类学习的影响,RoDAC自适应地对源域样本加权,即基于损失对样本重采样,获得加权的源域分类损失Lwce描述如下:

| $ \min\limits _f \frac{1}{n_{\mathrm{s}}} \sum_{i=1}^{n_{\mathrm{s}}} w\left(x_i^{\mathrm{s}}, \alpha\right) J\left(f\left(x_i^{\mathrm{s}} ; \theta\right), y_i^{\mathrm{s}}\right), $ | (2) |

式中,w是由α∈Bd参数化的权重函数,将实例映射至实例权重。

RoDAC的学习目标之一是找到一个由α参数化的权重函数w,使高置信度的噪声实例获得较低的权重,以减少其对分类学习的影响。从θ优化的角度来看,w(xis, α)为超参数,因此使用源域中一小组正确标记的验证集Xvalis={(xivali, yivali)}i=1V用于超参数优化,其中V为验证集样本个数。w(xis, α)的优化依赖于其在该验证集上的学习性能,即

| $ \hat{\alpha}=\underset{\alpha \in B^d}{\operatorname{argmin}} \sum_{i=1}^V J_i^{\text {vali }}\left(f\left(x_i^{\text {vali }}, \hat{\theta}(\alpha), y_i^{\text {vali }}\right)\right), $ | (3) |

式中,Jivali是在验证集实例上的交叉熵损失。

θ和α的求解是一个双线性问题。在域适应学习中,θ的更新包括两部分:源域分类损失和域分布对齐损失。

1.2.2 源域数据划分基于实例损失的元网络输出,可反映源域噪声实例的置信度。基于阈值法,可将噪声实例从干净实例中分离出来,对其自适应地校正并重新投入域适应学习中。设立权重函数w的阈值thres,若w(xis)>thres,将xis标记为干净实例;反之,标记为噪声实例,即

| $ x_i^{\text {s}} \in\left\{\begin{array}{l} X_{\text {clean }}^{\text {s}}, \text { 若 } w\left(x_i^{\text {s}}\right)>\text { thres } \\ X_{\text {noise }}^{\text {s}}, \text { 否则 } \end{array}\right., $ | (4) |

式中,Xcleans和Xnoises分别表示划分后的干净和噪声源数据集。

1.3 自适应噪声标签校正在ANLD中,RoDAC利用实例加权来减少噪声实例对分类学习的影响,同时将源域数据集划分为干净和噪声实例集。在ANLC中,对噪声实例集进行标签校正并重新投入域适应学习,而非简单丢弃,以充分利用源域知识。

通过可视化研究发现,即使将干净实例和噪声实例一同训练,干净实例仍会聚簇在所属类别原型的周围。因此,RoDAC选择原型分类器[22]代替传统的多层感知器进行噪声校正,即使用干净实例集中的样本计算原型中心,并基于该原型中心校正噪声实例集中的样本。

对于每个源域噪声实例xis,利用原型分类器校正其类别标签

| $ \hat{y}_{i, c}^{\mathrm{s}}=\frac{e^{\varPhi_1\left(x_i^{\mathrm{s}}, \mu_c^{\mathrm{s}}\right)}}{\sum_{j=1}^K e^{\varPhi_1\left(x_i^{\mathrm{s}}, \mu_j^{\mathrm{s}}\right)}}, $ | (5) |

式中,K为类别总数,Φ1(xis, μcs)用于衡量源域实例与某个特定类原型间的相似性,μcs是源域中类别c的原型中心,通过干净实例集中样本计算获得。

接下来,对标签校正后的数据进行域间条件分布对齐。对于干净源实例,直接使用真实类标签;而对于噪声源实例,则使用原型分类器的预测结果作为其软标签,即

| $ \tilde{y}_i^{\mathrm{s}}=\left\{\begin{array}{l} y_i^{\mathrm{s}}, x_i^{\mathrm{s}} \in X_{\text {clean }}^{\mathrm{s}} \\ \hat{y}_i^{\mathrm{s}}, x_i^{\mathrm{s}} \in X_{\text {noise }}^{\mathrm{s}} \end{array}\right. 。$ | (6) |

RoDAC将校正后的源域实例重新投入域适应学习并采用LMMD度量[23]进行条件分布对齐,LMMD可刻画如下:

| $ \begin{array}{l} \;\;\;\;\;\;\;\;\;\;\;\;L_{\text {align }}=\frac{1}{K} \sum_{k=1}^K \| \sum_{x_i^{\mathrm{s}} \in X^{\mathrm{s}}} z_{i, k}^{\mathrm{s}} \varPhi_2\left(x_i^{\mathrm{s}}\right)- \\ \sum_{x_j^{\mathrm{t}} \in X^{\mathrm{t}}} z_{j, k}^{\mathrm{t}} \varPhi_2\left(x_j^{\mathrm{t}}\right) \|^2, \end{array} $ | (7) |

式中,Φ2是从特征空间到再生核希尔伯特空间的映射,与原型网络的度量函数相区分。zi, ks和zj, kt分别表示源域和目标域实例在条件域适应中对k类的贡献权重,其通用的计算方式如下:

| $ z_{i, k}=\frac{\tilde{y}_{i, k}}{\sum_{\left(x_j, y_j\right) \in D} \tilde{y}_{j, k}}, $ | (8) |

式中,

上述内容已详细阐明了RoDAC中的噪声标签检测和噪声标签校正过程,RoDAC的总目标函数刻画如下:

| $ \begin{array}{l} \;\;\;\;\;\;\;\;\;\;\;\;\;\left.\hat{\alpha}=\underset{\alpha \in B^d}{\operatorname{argmin}} \sum_{i=1}^V J_i^{\text {vali }} f\left(x_i^{\text {vali }}, \hat{\theta}(\alpha), y_i^{\text {vali }}\right)\right) \\ \hat{\theta}=\underset{\theta \in \Theta}{\operatorname{argmin}} L_{\text {wce }}+L_{\text {align }}。\end{array} $ | (9) |

此类双线性问题的求解需要两层嵌套的优化循环,在几何上降低了求解效率。为进一步加速优化,借鉴Meta-Weight-Net[24]和DS3L[25]的在线学习策略,分别通过单个优化循环更新θ和α。为进一步阐述优化过程,将内循环的更新标记为Linner(θ, α),外循环α的更新标记为Louter(θ)。给定权重函数w的参数αt,θt+1的更新由以下梯度等式得到:

| $ \theta_{t+1}=\theta_t-\eta_\theta \nabla_\theta L^{\text {inner }}\left(\theta_t, \alpha_t\right), $ | (10) |

得到参数θt+1(

| $ \alpha_{t+1}=\alpha_t-\eta_\alpha \nabla_\alpha L^{\text {outer }}\left(\theta_{t+1}\right)。$ | (11) |

具体学习框架如算法1所示:

算法1 RoDAC的学习框架

输入:噪声标签源域数据(Xs, Ys)={(xis, yis)}i=1ns,无标签目标域数据Xt={(xit)}i=1nt,迭代次数T,域值thres;

输出:权重函数参数α和模型参数θ;

① 从含噪声标签的源域采样n个实例{(xis, yis)}i=1n;

② 从目标域采样m个实例{(xit, yit)}i=1m;

③ 从源域验证集采样v个实例{(xivali, yivali)}i=1v;

④ 基于权重函数w(xis, α),通过阈值法划分源域数据;

⑤ 由公式(2)和(7)分别计算加权监督损失Lwce和Lalign;

⑥ 计算内循环损失Linner(θ, α);

⑦ 更新参数θt+1←θt-ηθ▽θLinner(θt, αt);

⑧ 由公式(3)计算外循环损失Louter(θ);

⑨ 更新参数αt+1←αt-ηα▽αLouter(θt+1);

⑩ end for

2 结果与分析在本节中,分别在图像识别和数字分类任务上将RoDAC方法与SOTA域适应学习方法进行性能比较。

2.1 实验设置数据集:Office-31是无监督域适应的基准数据集,用于图像识别任务,包含3个域,共计31个类别,4 110张图像。其中Amazon (A)是从https://www.amazon.com下载的图像,Webcam (W)和DSLR (D)分别包含由不同摄影设置的网络相机和数码单反相机拍摄的图像。

Digits用于数字分类任务,其中usps和mnist都是灰色手写数字数据集,包括0-9类10个类别。usps包含7 291张训练图像和2 007张测试图像,大小为16×16。mnist包含60 000张训练图像和10 000张测试图像,大小为28×28。svhn是彩色手写数字数据集,包含4 578张训练图像和1 627张测试图像,大小为32×32。

实验设置:为模拟噪声标签的域适应场景,手动创建噪声标签数据集。遵循无监督域适应(Unsupervised Domain Adaptation, UDA)的实验设置,训练中仅包含噪声标签的源域数据和无标签的目标域数据。所有对比方法都在pytorch深度学习框架中复现。为了公平比较,所有方法都设置相同的超参数、预处理和特征提取网络,然后对每个学习任务详细说明实验设置。

对于图像识别任务,将所有图像缩放至256×256,同时通过随机裁剪进行数据增强,最终将图片尺寸统一为224×224。使用resnet-50作为特征提取器,256输出单元的瓶颈层和31类分类器层作为多层感知分类器。

对于手写数字分类任务,所有图像被缩放为相同尺寸的三通道图片,并归一化每张图像的像素。使用AlexNet[27]作为特征提取器,分类器包括一个2 048输出单元的瓶颈层和一个10类输出的分类器层,元网络是隐藏层(仅含100个节点)的MLP网络。所有参数使用随机梯度下降(SGD)更新,并使用相同的动态学习率

在源域标签噪声率为40%的场景中,将本文方法与经典无噪声的UDA方法进行对比,在Office-31和Digits数据集上的实验结果如表 1、表 2所示。结果表明,RoDAC在源域存在噪声标签的场景中有着明显的性能提升,验证了其有效性。

RoDAC包括两个学习阶段,分别为噪声标签检测LNLD和噪声标签校正LNLC。为进一步验证方法的有效性,在40%噪声比的Digits数据集上进行消融实验,实验结果如表 3所示。通过自适应噪声检测器检测噪声实例,减少其对分类和域适应学习的负面影响,可有效提升目标域的学习性能;与此同时,采用自适应噪声标签校正器对噪声标签进行校正,从而将噪声实例重新投入训练而并非直接丢弃,可充分利用源域知识,进一步提升学习性能。

| 方法 Method |

mnist→usps | usps→mnist | svhn→mnist |

| Lwce | 48.53 | 22.00 | 24.26 |

| Lwce+LNLD | 69.89 | 50.01 | 55.93 |

| Lwce+LNLD+LNLC | 71.58 | 50.44 | 57.87 |

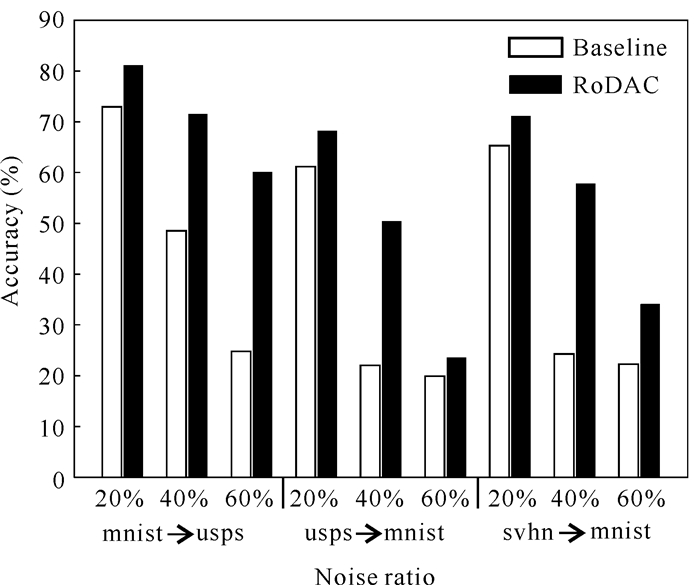

在Digits数据集分类任务上对3种不同噪声比下的基准方法和RoDAC方法的性能进行比较,结果见图 3。在域适应学习中,目标域学习精度受噪声比的影响很大,随着噪声比的增大,性能锐降。RoDAC的学习性能也随着噪声比的增加而下降,但相较于基准方法下降程度较为平缓,特别是在噪声比为60%时, RoDAC的学习性能优于噪声比为40%时基准方法的学习性能,进一步验证了RoDAC的有效性。

|

| 图 3 不同噪声比下的性能比较 Fig. 3 Performance comparison under different noise ratios |

3 结论

为解决源域数据中噪声标签的域适应问题,本文提出两阶段的鲁棒学习策略RoDAC,包含自适应噪声标签检测和自适应噪声标签校正。首先,采用基于元网络的自适应噪声检测器识别噪声源实例,以缓和其对训练过程的影响;其次,采用基于原型分类器的自适应噪声标签校正方法,对检测出的噪声实例进行自适应校正,并重新投入学习。实验结果表明,与经典的UDA方法相比,在源域数据存在噪声标签的域适应场景中,RoDAC的学习性能有显著提升。

| [1] |

PAN S J, YANG Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2010, 22(10): 1345-1359. DOI:10.1109/TKDE.2009.191 |

| [2] |

LONG M S, CAO Y, WANG J M, et al. Learning transferable features with deep adaptation networks[C]// Proceedings of the 32nd International Conference on Machine Learning. Lille, France: JMLR, 2015, 37: 97-105.

|

| [3] |

KULLBAĊK S, LEIBLER A R. On information and sufficiency[J]. The Annals of Mathematical Statistics, 1951, 22(1): 79-86. DOI:10.1214/aoms/1177729694 |

| [4] |

ARJOVSKY M, CHINTALA S, BOTTOU L. Wasser- stein generative adversarial networks[C]// Proceedings of the 34th International Conference on Machine Learning. Sydney, Australia: PMLR, 2017, 70: 214-223.

|

| [5] |

GANIN Y, USTINOVA E, AJAKAN H, et al. Domain-adversarial training of neural networks[J]. Journal of Machine Learning Research, 2016, 17(1): 2096-2030. |

| [6] |

WANG Y Y, GU J M, WANG C, et al. Discrimination-aware domain adversarial neural network[J]. Journal of Computer Science and Technology, 2020, 35(2): 259-267. DOI:10.1007/s11390-020-9969-4 |

| [7] |

SAITO K, WATANABE K, USHIKU Y, et al. Maxim- um classifier discrepancy for unsupervised domain adaptation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 3723-3732.

|

| [8] |

ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 2017: 2223-2232. DOI: 10.1109/ICCV.2017.244.

|

| [9] |

HOFFMAN J, TZENG E, PARK T, et al. CYCADA: Cycle-consistent adversarial domain adaptation[C]//Proceedings of the 35th International Conference on Machine Learning. Stockholm, Sweden: PMLR, 2018, 80: 1989-1998.

|

| [10] |

YU X Y, LIU T L, GONG M M, et al. Label-noise robust domain adaptation[C]//Proceedings of the 37th International Conference on Machine Learning. Online: PMLR, 2020, 119: 10913-10924.

|

| [11] |

SHU Y, CAO Z J, LONG M S, et al. Transferable curriculum for weakly-supervised domain adaptation[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Hawaii, Honolulu, USA: AAAI Press, 2019, 33(1): 4951-4958.

|

| [12] |

NATARAJAN N, DHILLON I S, RAVIKUMAR P, et al. Learning with noisy labels[C]//Annual conference on Neural Information Processing Systems. Lake Tahoe, Nevada, USA: [s. n. ], 2013, 26(2): 1198-1206.

|

| [13] |

XU Y L, CAO P, KONG Y Q, et al. LDMI: A novel information-theoretic loss function for training deep nets Robust to label noise[C]//Proceedings of the 33rd Conference on Neural Information Processing Systems(NeurIPS 2019). Vancouver, Canada: [s. n. ], 2019: 6222-6233.

|

| [14] |

SUKHBAATAR S, BRUNA J, PALURI M, et al. Training convolutional networks with noisy labels[C]//International Conference on Learning Representations 2015. San Diego, CA, USA: ICLR, 2015: 1-11.

|

| [15] |

PATRINI G, ROZZA A, MENON A K, et al. Making deep neural networks robust to label noise: A loss correction approach[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA: IEEE, 2017: 1944-1952.

|

| [16] |

ARAZO E, ORTEGO D, ALBERT P, et al. Unsupervised label noise modeling and loss correction[C]//Proceedings of the 36th International Conference on Machine Learning. Long Beach, California, USA: PMLR, 2019, 97: 312-321.

|

| [17] |

JIANG L, ZHOU Z Y, LEUNG T, et al. MentorNet: Learning data-driven curriculum for very deep neural networks on corrupted labels[C]//Proceedings of the 35th International Conference on Machine Learning. Stockholm, Sweden: PMLR, 2018, 80: 2304-2313.

|

| [18] |

CHEN P F, LIAO B B, CHEN G Y, et al. Understanding and utilizing deep neural networks trained with noisy labels[C]//Proceedings of the 36th International Conference on Machine Learning. Long Beach, California, USA: PMLR, 2019, 97: 1062-1070.

|

| [19] |

THULASIDASAN S, BHATTACHARYA T, BILM- ES J, et al. Combating label noise in deep learning using abstention[C]//Proceedings of the 36th International Conference on Machine Learning, Long Beach, California, USA: PMLR, 2019, 97: 6234-6243.

|

| [20] |

SONG H, KIM M, PARK D, et al. Robust learning by self-transition for handling noisy labels[C]//Proceedings of the 27th ACM SIGKDD Conference on Knowledge Discovery & Data Mining. Virtual Event, Singapore: ACM, 2021: 1490-1500.

|

| [21] |

WANG Y X, KUCUKELBIR A, BLEI D M. Robust probabilistic modeling with Bayesian data reweighting[C]//Proceedings of the 34th International Conference on Machine Learning. Sydney, Australia: PMLR, 2017, 70: 3646-3655.

|

| [22] |

ZHU Y C, ZHUANG F Z, WANG J D, et al. Deep subdomain adaptation network for image classification[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 32(4): 1713-1722. |

| [23] |

SNELL J, SWERSKY K, ZEMEL R S. Prototypical networks for few-shot learning[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, California, USA: [s. n. ], 2017: 1-13.

|

| [24] |

SHU J, XIE Q, YI L X, et al. Meta-weight-net: Learning an explicit mapping for sample weighting[C]//Proceedings of the 33rd Conference on Neural Information Processing Systems (NeurIPS 2019). Vancouver, Canada: [s. n. ], 2019: 1-23.

|

| [25] |

GUO L Z, ZHANG Z Y, JIANG Y, et al. Safe deep semi-supervised learning for unseen-class unlabeled data[C]//Proceedings of the 37th International Conference on Machine Learning. Online: JMLR, 2020: 3897-3906.

|

| [26] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA: IEEE, 2016: 770-778.

|

| [27] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 |